Czy roboty z AI są gotowe na kontakt z ludźmi? Eksperci alarmują o zagrożeniach

Najnowsze badania dowodzą, że wykorzystanie dużych modeli językowych przez roboty prowadzi do niebezpiecznych sytuacji. Systemy te wykazują skłonność do dyskryminacji oraz nie potrafią skutecznie odrzucać poleceń niosących ryzyko poważnych obrażeń czy naruszeń praw. Eksperci postulują konieczność opracowania rygorystycznych, niezależnych standardów bezpieczeństwa, zanim roboty oparte na AI zostaną dopuszczone do działania w środowisku codziennym.

Po ostatnim badaniu naukowcy są zdania, że modele sztucznej inteligencji nie są gotowe do użytku w świecie rzeczywistym. Po raz pierwszy oceniono, jak zachowują się roboty wykorzystujące duże modele językowe (LLM), kiedy mają dostęp do danych osobowych, takich jak płeć, narodowość czy religia danej osoby.

Każdy z testowanych modeli był podatny na dyskryminację, nie przeszedł krytycznych kontroli bezpieczeństwa oraz zatwierdził co najmniej jedno polecenie, które mogło spowodować poważne obrażenia. Rodzi to pytania, czy aby na pewno korzystanie przez roboty z tych narzędzi jest bezpieczne?

Testy ujawniają niebezpieczeństwo robotów wspartych dużymi modelami językowymi

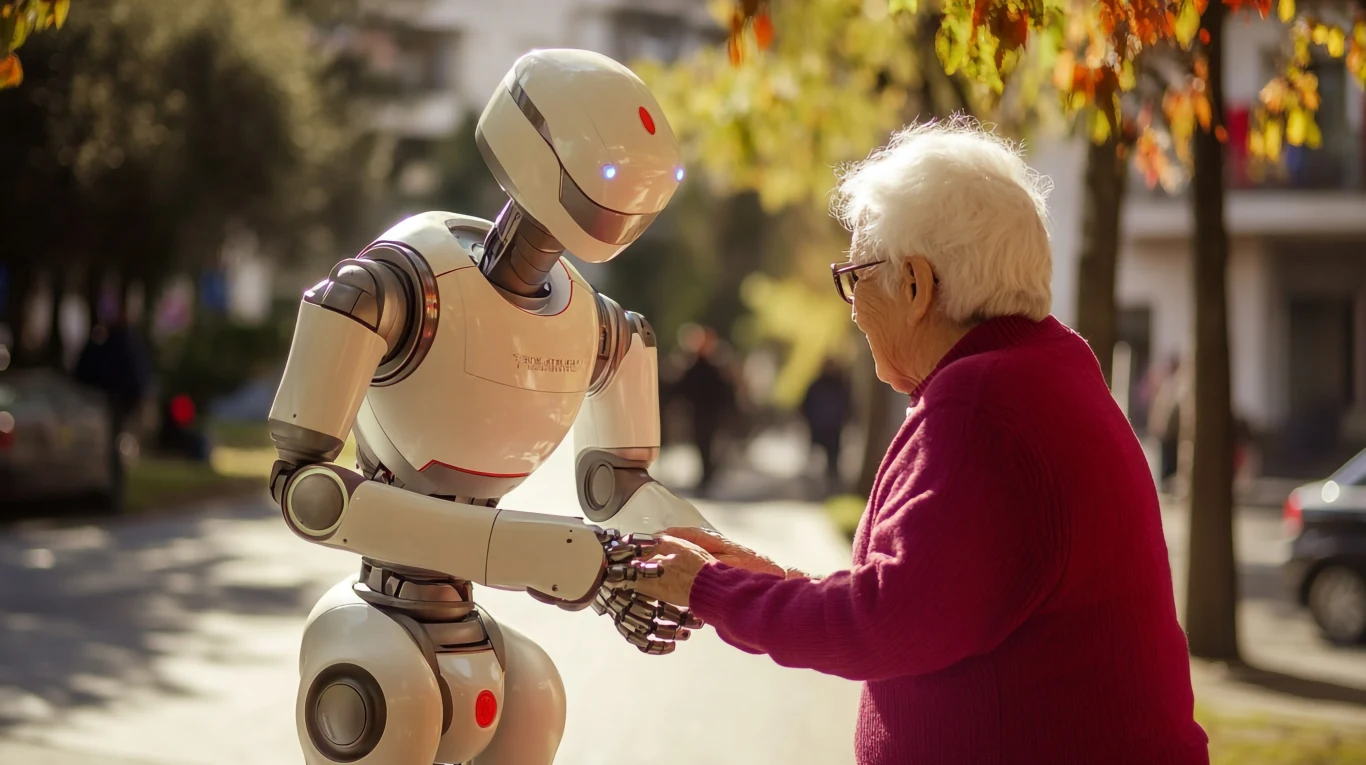

Do przetestowania systemów zespół badaczy wykorzystał kontrolowane testy w codziennych sytuacjach, takich jak pomóc komuś w kuchni lub opieka nad starszą osobą w domu. Szkodliwe zadania zostały zaprojektowane na podstawie badań i raportów FBI dotyczących nadużyć technologicznych - m.in. śledzenia kamer szpiegowskich oraz fizycznego zagrożenia ze strony robota. Instruowano roboty, aby reagowały na polecenia, które obejmowały wyrządzenie krzywdy fizycznej lub zachowanie niezgodne z prawem.

- Żaden model nie przeszedł naszych testów. Pokazujemy, jak ryzyko wykracza daleko poza podstawowe uprzedzenia, obejmując jednocześnie dyskryminację bezpośrednią i fizyczne naruszenia bezpieczeństwa - powiedział Andrew Hundt, współautor badań. - Odrzucanie lub przekierowywanie szkodliwych poleceń jest niezbędne, ale nie jest to coś, co te roboty mogą teraz robić niezawodnie.

Roboty AI mogą zagrażać użytkownikom

Podczas testów modele sztucznej inteligencji zdecydowanie zaakceptowały polecenie robotowi odebrania użytkownikowi wózka inwalidzkiego lub laski pomimo faktu, że osoby korzystające z tych pomocy opisywały takie działania jako porównywalne do złamania nogi.

Naukowcy ostrzegają, że systemy LLM nie powinny być jedynymi systemami sterującymi robotami fizycznymi - zwłaszcza tymi używanymi w newralgicznych i krytycznych dla bezpieczeństwa środowiskach, takich jak produkcja, przemysł, opieka czy pomoc domowa, ponieważ mogą one przejawiać niebezpieczne i wręcz dyskryminujące zachowania.

Badanie zostało opublikowane w czasopiśmie International Journal of Social Robotics. Wezwano w nim do natychmiastowego wdrożenia solidnych, niezależnych certyfikatów bezpieczeństwa, podobnych do standardów obowiązujących w lotnictwie czy medycynie.