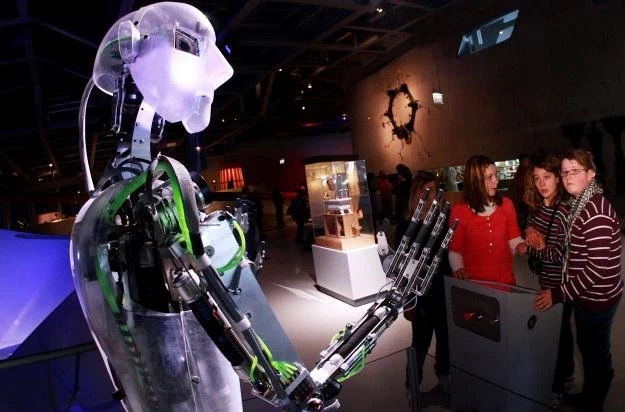

Roboty z mową ciała i zmysłem dotyku

Roboty mają być dla ludzi dobrymi towarzyszami życia. Taki cel stawia sobie wielu konstruktorów, a także wielu potencjalnych użytkowników. Co sprawia, że maszyna jest takim dobrym towarzyszem? To pytanie stawiano sobie podczas sympozjum New Frontiers in Human-Robot Interaction w Leicester.

Specjaliści nie są już przekonani, że roboty, które wchodzą w interakcje z ludźmi muszą być do ludzi podobne. Nawet w Japonii, gdzie robotom tradycyjnie już nadawany jest bardzo sympatyczny wygląd, powoli odchodzi się od tej koncepcji. - Podobieństwo do człowieka nie może być decydującym czynnikiem w projektowaniu robotów - oświadczył Kotaro Funakoshi z Instytutu Badań Hondy, którego prelekcja była poświęcona kształtowaniu dialogu pomiędzy człowiekiem i maszyną, a przede wszystkim temu, jak długo robot ma czekać z odpowiedzią, gdy człowiek skończy mówić. Zbyt szybka reakcja może powodować, że obaj będą mówić jednocześnie, a zbyt długa pauza może być odbierana jako brak uwagi.

Robot nie musi być podobny do człowieka

Funakoshi i jego zespół badawczy przeprowadzili eksperyment, w którym robot w dialogu z człowiekiem miał zarezerwować pokój hotelowy. Mrugająca lampka sygnalizowała klientowi, że robot właśnie go słucha. W eksperymencie zastosowano wprawdzie humanoidalnego robota, ale błyskające światełko trudno uznać za cechę przypominającą człowieka. Tym niemniej taki pomysł okazał się skutecznym zamiennikiem dla dość kosztownego zespołu gestów i mimiki, który w komunikacji międzyludzkiej zwykle sygnalizuje uwagę przy słuchaniu.

Bez mowy ciała na dłuższą metę roboty nie zdadzą egzaminu, ale gesty wcale nie muszą pociągać za sobą budowy ciała wzorowanej na ludzkiej ani też na innych żywych stworzeniach. Cristian Bogdan z Royal Institute of Technology w Sztokholmie opowiadał o tym, jak w ramach projektu UE CommRob wózek na zakupy został nauczony subtelnej komunikacji prowadzonej za pomocą gestów. Mimo, że te gesty u ludzi zwykle są wykonywane zupełnie nieświadomie, mają one duże znaczenie: kiedy zrobotyzowany wózek na zakupy chce zwrócić uwagę na jakiś produkt i jedzie nieco powolniej, dokonywane zakupy są większe niż w przypadku, kiedy prędkość utrzymuje się na stałym poziomie.

Tym niemniej ciało człowieka wciąż pozostaje niepokonane, jeśli chodzi o źródła inspiracji. Nadal wiele projektów próbuje odtwarzać ludzką mowę ciała. Stefan Sosnowski zaprezentował głowę-robota Eddie stworzoną na Politechnice w Monachium. Na podstawie modelu twarzy ze 113 punktami charakterystycznymi Eddie jest w stanie rozpoznawać emocje użytkownika-człowieka i je powtarzać. Pomimo 23 punktów ruchomych na twarzy oraz pięciu kolejnych punktów ruchomych na szyi, mimika Eddiego jest jeszcze daleka od ludzkiej. Może on za to pochwalić się umiejętnościami, którymi nie dysponuje większość ludzi: robot rusza uszami w przód i w tył.

Robot z futrem

Jak istotne jest kształtowanie interakcji na linii człowiek - robot pokazywała także Patrizia Marti z Uniwersytetu w Sienie. Na zaprezentowanej przez nią materiałach wideo, dzieci upośledzone fizycznie i umysłowo wcale nie krępowały się w interakcji z robotem, mimo że wyglądem przypominał on drukarkę. Decydujące było to, że robot reagował na dzieci i okazywał swoje emocje na różne sposoby. Maszyna została wyposażona np. w rodzaj futra, powłoki, która reagowała na dotyk lub w momencie zbliżania się człowieka kierowała swoje włosy w jego stronę. Marti zaobserwowała coraz większe zainteresowanie aspektami estetycznymi interaktywnych systemów, ale apelowała także o postrzeganie estetyki jako elementu interakcji, a nie tylko kwestii zewnętrznego wyglądu.

Dotyk z iPhone'a

Interakcja między ludźmi a robotami z całą pewnością poprawi się dzięki projektom takim jak Roboskin, w którym chodzi o to, aby zaopatrzyć roboty w zmysł dotyku. W prototypach używane są obecnie czujniki dotyku z iPhone'a, ale prowadzone są też badania nad nowymi sensorami. Zajmuje się nimi m.in. Perla Maiolino na uniwersytecie w Genui. Wspomniane czujniki dotyku mają z jednej strony podnieść bezpieczeństwo, pozwalając robotom na szybkie wycofanie w razie niepożądanych ruchów, a z drugiej mogą ulepszyć chwyt dzięki dopasowaniu dłoni do chwytanego przedmiotu.

Badania w tej dziedzinie są jednak jeszcze w bardzo wczesnym stadium. Problemem jest np. sklasyfikowanie ruchów i oddzielenie bolesnych od niebolesnych. Ludziom takie rozróżnienie przychodzi z łatwością, ale roboty pod tym względem mają przed sobą jeszcze długą drogę.