Jest lepszy niż nasi koszykarze. Unitree G1 gra w kosza

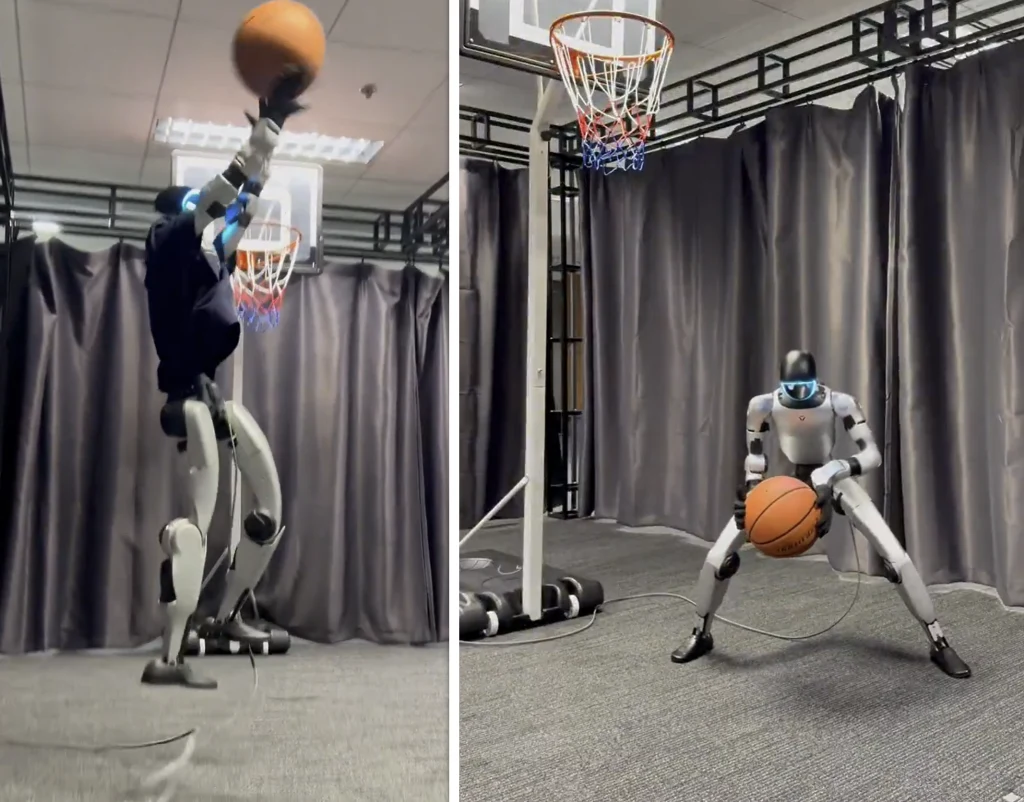

Roboty grające w koszykówkę? Brzmi jak scena z filmu sci-fi, ale Unitree G1 o wdzięcznym przydomku "Mały Ziemniak", właśnie zrobił ogromny krok w stronę humanoidalnej atletyki. W laboratorium Uniwersytetu Nauk i Technologii w Hongkongu (HKUST) robot zaprezentował płynny drybling, podania, a nawet layup, pokazując, że sztuczna inteligencja może uczyć roboty prawdziwych sportowych ruchów.

Sekret sukcesu G1 kryje się w SkillMimic, systemie AI, który analizuje ludzkie ruchy rejestrowane za pomocą wideo i specjalnych kombinezonów z sensorami ruchu. Następnie w wirtualnej symulacji dopracowuje te ruchy, aż staną się wystarczająco stabilne, by robot mógł je powtórzyć w rzeczywistości. To pozwala nauczyć robota wielu umiejętności, więc G1 potrafi płynnie przełączać się między dryblingiem, podaniami i rzutami, nawet jeśli takie kombinacje nie były obecne w danych referencyjnych.

Pierwsze koszykarskie kroki w świecie robotów

Wideo z laboratorium pokazuje, jak kompaktowy humanoid sunie po boisku i trafia do kosza z zadziwiającą naturalnością i szybkością. Podczas pokazu G1 próbował wykonać layup, który został zablokowany przez badacza, ale robot jednak błyskawicznie odzyskał równowagę i kontynuował grę, prezentując imponującą stabilność.

System SkillMimic-V2 rozwiązuje poważny problem uczenia się przez wzmacnianie z demonstracji, ponieważ rzeczywiste dane dotyczące ruchu są często chaotyczne. Demonstracje ludzi mogą być lakoniczne, chaotyczne i pozbawione płynnych przejść niezbędnych do nauki złożonych umiejętności przez robota. Zamiast starać się gromadzić idealne dane, zespół argumentuje, że nawet wadliwe nagrania zawierają wystarczającą ilość użytecznych informacji, o ile zostaną odpowiednio przetworzone.

Jak robot uczy się płynnych ruchów? SkillMimic-V2 wykorzystuje trzy główne techniki:

- Stitched Trajectory Graph (STG) - łączy podobne pozycje ciała w różnych umiejętnościach, tworząc nowe ścieżki przejścia między ruchami, których robot nigdy nie widział.

- State Transition Field (STF) - zmienia punkt startowy każdego ćwiczenia, zmuszając robota do nauki radzenia sobie z błędami.

- Adaptive Trajectory Sampling (ATS) - kładzie większy nacisk treningowy na trudne momenty ruchu, aby robot nie zawodził w dłuższych sekwencjach.

Symulacje rządzą nauką

Zespół HKUST przetestował system na czterech zaawansowanych zadaniach, używając jednej strategii sterowania do nauki siedmiu podstawowych ruchów (różne dryblingi, layupy, rzuty i podnoszenie piłki). Łącznie robot trenował na 4,5 miliarda symulowanych próbek.

Prostsze zadania, jak podanie czy przemieszczanie się po boisku, wymagały około 0,4 miliarda kroków treningowych, a trudniejsze, jak zdobycie punktu, aż 1,2 miliarda. W porównaniu z innymi metodami, które polegały na danych z ruchu od podstaw lub starszych technikach, SkillMimic pozwolił robotowi uzyskać znacznie lepszą precyzję i interakcję z piłką.

Naukowcy nie spoczywają jednak na laurach. Plany obejmują naukę obsługi różnych obiektów, skracanie czasu potrzebnego na trening i w końcu nawet wdrażanie tych umiejętności na prawdziwe boiska w pełnych grach koszykarskich. Wygląda więc na to, że już niedługo możemy doczekać się jeszcze bardziej zaawansowanych igrzysk olimpijskich robotów, choć już tegoroczne World Humanoid Robot Games w Pekinie wyglądało naprawdę imponująco.