Sztuczna inteligencja doskonale podsłuchuje miasta

Czy na podstawie dźwięków można dokładnie odtworzyć wygląd przestrzeni? Okazuje się, że sztuczna inteligencja robi to całkiem nieźle. Na podstawie nagrań audio z dużą dokładnością wygenerowała obrazy miast, zachowując nawet takie szczegóły jak pogoda czy pora dnia.

Sztuczna inteligencja generuje obrazy miasta na podstawie dźwięku

Nowa technologia opracowana przez zespół badaczy z University of Texas w Austin generuje obrazy, które pasują do nagrań dźwiękowych ulic i robi to z niesamowitą dokładnością. Opracowany przez dr. Yuhao Kanga, adiunkta geografii i środowiska na UT i jego współpracowników „Soundscape-to-Image Diffusion Model” został wytrenowany na zestawie 10-sekundowych klipów audiowizualnych. Były to statyczne obrazy wraz z dźwiękami otoczenia pozyskane z filmów dostępnych w internecie. Przedstawiały one ulice miast i wsi w Ameryce Północnej, Azji i Europie.

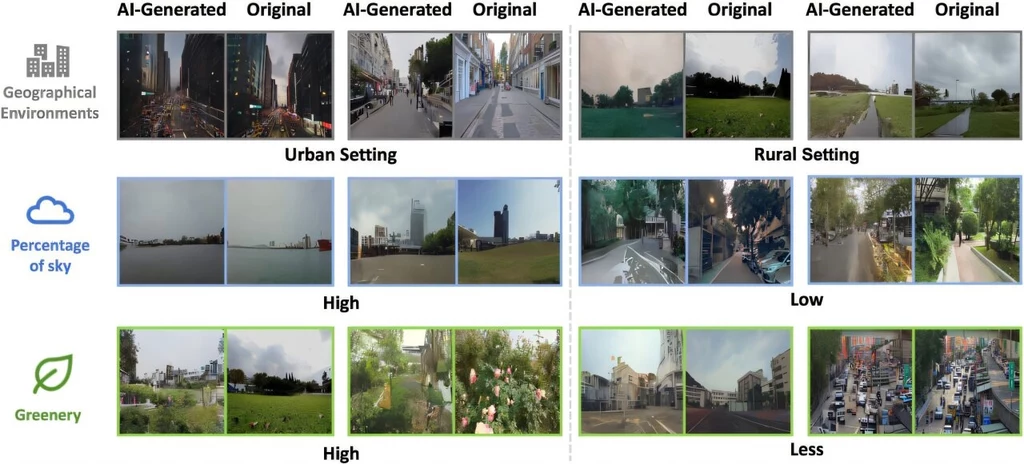

Po zakończeniu szkolenia sztuczna inteligencja miała wygenerować obrazy wyłącznie na podstawie nagrań audio otoczenia ze 100 innych filmów. Z każdego klipu miał być wygenerowany jeden obraz. Poniższy zestaw pokazuje przykładowe efekty.

Następnie sędziowie ludzcy mieli za zadanie prawidłowo dopasować jeden z trzech wygenerowanych obrazów do próbki audio. Gdy poproszono ich o wskazanie, który z trzech obrazów odpowiada ścieżce dźwiękowej, uzyskali średnio 80 proc. dokładności. Przeprowadzono także komputerową analizę wygenerowanych obrazów, podczas której porównano proporcje zieleni, nieba i budynków na oryginalnych kadrach i obrazach stworzonych przez model. Okazało się, że szczególnie dobre wyniki zostały uzyskane w przypadku ziemi i nieba, nieco mniejszą korelację zauważono w przypadku budynków, ale efekt i tak był zaskakujący.

Nasze badanie wykazało, że środowiska akustyczne zawierają wystarczająco dużo wskazówek wizualnych, aby generować wysoce rozpoznawalne obrazy krajobrazu ulicznego, które dokładnie przedstawiają różne miejsca. Oznacza to, że możemy przekształcić środowiska akustyczne w żywe reprezentacje wizualne, skutecznie tłumacząc dźwięki na widoki.

Oprócz przybliżonego oddania proporcji nieba, zieleni i budynków, wygenerowane obrazy często zachowywały styl architektoniczny i odległości między obiektami odpowiadające ich rzeczywistym obrazom, a także dokładnie odzwierciedlały, czy pejzaże dźwiękowe były nagrywane w słonecznych, zachmurzonych czy nocnych warunkach oświetleniowych.

Autorzy zwrócili uwagę, że informacje o oświetleniu mogą pochodzić ze zmian aktywności w krajobrazach dźwiękowych. Na przykład dźwięki ruchu ulicznego lub ćwierkanie nocnych owadów mogą ujawnić porę dnia. – Kiedy zamykasz oczy i słuchasz, dźwięki wokół ciebie malują obrazy w twoim umyśle. Na przykład, odległy szum ruchu ulicznego staje się gwarnym miejskim krajobrazem, podczas gdy delikatny szelest liści wprowadza cię do spokojnego lasu. Każdy dźwięk tka żywy gobelin scen, jakby za sprawą magii, w teatrze twojej wyobraźni – powiedział dr Kang.

Jak można w praktyce wykorzystać nowe badania?

Wygenerowane obrazy wymagają dopracowania, ale i tak trzeba przyznać, zaskakująco dokładnie potrafią odwzorować krajobraz na podstawie samych dźwięków. Myśląc o praktycznym zastosowaniu, być może i wam przychodzi na myśl kryminalistyka i możliwość ustalenia miejsca zdarzenia na podstawie nagrania. Jednak na tym etapie badania skupiają się na zbadaniu wpływu dźwięku na nasze poczucie przestrzeni.

— Wyniki mogą poszerzyć naszą wiedzę na temat wpływu percepcji wzrokowej i słuchowej na zdrowie psychiczne człowieka, mogą posłużyć jako wskazówka w praktykach projektowania miast pod kątem kształtowania przestrzeni oraz mogą poprawić ogólną jakość życia w społecznościach — stwierdzają naukowcy w artykule opublikowanym w czasopiśmie Computers, Environment and Urban Systems.

Źródła:

1. University of Texas at Austin

2. Yonggai Zhuang et al, From hearing to seeing: Linking auditory and visual place perceptions with soundscape-to-image generative artificial intelligence, Computers, Environment and Urban Systems (2024). DOI: 10.1016/j.compenvurbsys.2024.102122

3. Kee Moon Jang et al, Place identity: a generative AI's perspective, Humanities and Social Sciences Communications (2024). DOI: 10.1057/s41599-024-03645-7

***

Bądź na bieżąco i zostań jednym z 88 tys. obserwujących nasz fanpage - polub Geekweek na Facebooku i komentuj tam nasze artykuły!