ChatGPT pisze za naukowców prace w recenzowanych czasopismach

Nie tylko uczniowie wykorzystują ChatGPT do tworzenia prac pisemnych do szkoły. Według badania polskiego naukowca, tego typu pomoc wykorzystują także naukowcy, którzy następnie publikują tekst pod własnym nazwiskiem w recenzowanych czasopismach. Bywa jednak, że nawet nie przeczytają tekstu i umkną im frazy typowe dla narzędzi opartych na sztucznej inteligencji. Dominuje tu jedna dziedzina.

Na rynku obecnie spotkamy co najmniej kilka dużych modeli językowych (LLM). To m.in. Google Gemini, Meta Llama, Mixtral czy OpenChat. Jednak zdecydowanie tym najbardziej znanym i powszechnie wykorzystywanym jest ChatGPT, który został publicznie udostępniony w listopadzie 2022 r. Szybko zyskał popularność na całym świecie, stając się najszybciej subskrybowaną usługą w historii internetu.

Najczęściej w mediach możemy przeczytać historie o wykorzystywaniu sztucznej inteligencji przez uczniów, którzy, wykorzystując generatory tekstu, zaczęli usprawniać pisanie rozprawek czy innych dłuższych prac. Zalewają nas też stosy reklam zachęcających do wykorzystania AI w biznesie do tworzenia grafik, raportów, opisów produktów lub innych treści, w tym postów na media społecznościowe. Okazuje się, że to stosunkowo nowe narzędzie zdobyło grono zwolenników także w świecie nauki, co zbadał prof. Artur Strzelecki z Uniwersytetu Ekonomicznego w Katowicach.

Naukowcy korzystają z ChataGPT i piszą pracę poprzez kopiuj-wklej

W świecie nauki liczą się punkty i cytowania. Z tego powodu naukowcy często publikują wyniki badań w języku angielskim, wówczas jest większa szansa, że zostanie zauważona. Wysyłanie prac w języku ojczystym w zasadzie sprawia, że artykuł będzie wykorzystywany przede wszystkim lokalnie (żeby była jasność, takie teksty też są wartościowe i potrzebne. Jeśli dotyczą problemu charakterystycznego dla konkretnego obszaru, są również cytowane przez innych krajowych badaczy). Niemniej jednak wielu naukowców uważa, że jeśli mówimy o świecie nauki, to tam język angielski przestaje być językiem "obcym".

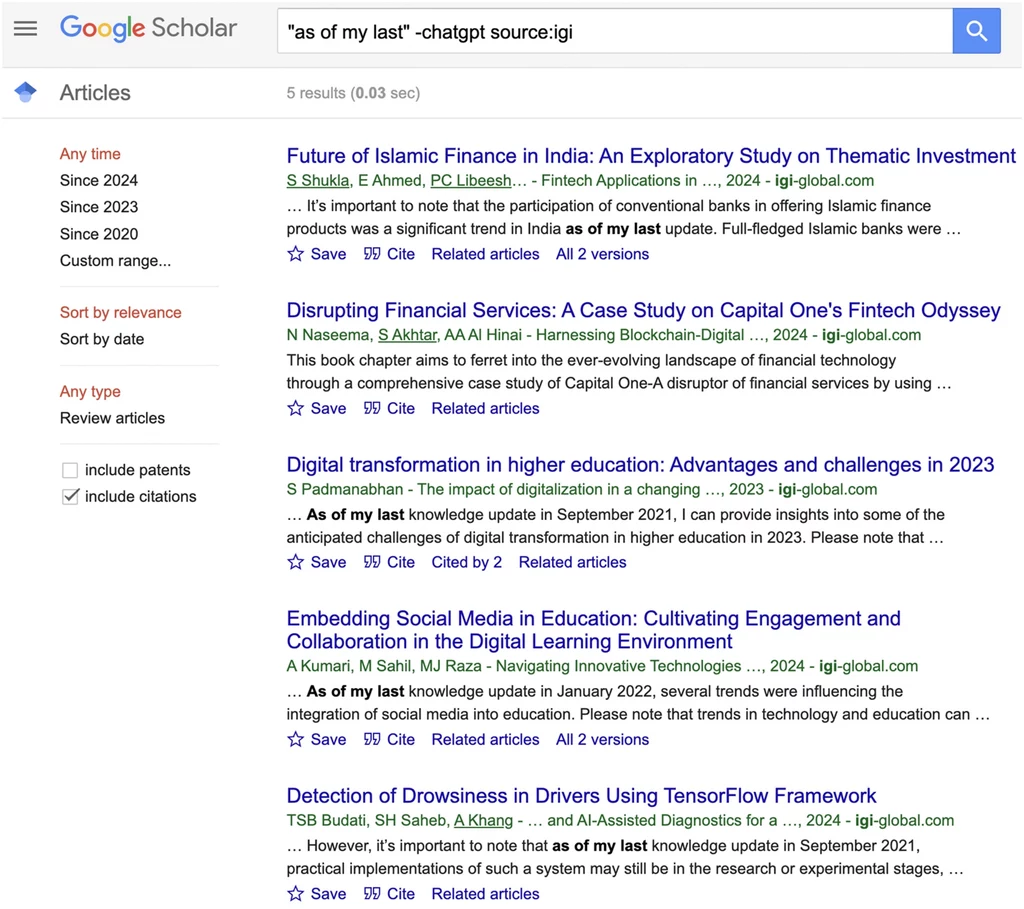

Prof. Strzelecki postanowił więc przyjrzeć się publikacjom anglojęzycznym i wyszukać pewne charakterystyczne dla ChataGPT, nienaturalne dla ludzi (nawet w specyficznym naukowym stylu pisania) struktury. Przeszukując bazę tekstów dostępną w wyszukiwarce GoogleScholar odkrył takie frazy jak: "Według mojej wiedzy na dzień ostatniej aktualizacji…" ("as of my last knowledge update"), "Jako model językowy AI" ("as an AI language model") czy "nie mam dostępu do aktualnych…" ("I don’t have access to real-time…").

Co ciekawe, przed publikacją tych wpadek nie zauważyli ani współautorzy, ani recenzenci, ani wydawcy. Prof. Strzelecki wyniki swoich analiz opublikował w czasopiśmie Learned Publishing. W swoim artykule wskazał, że treści generowane przez sztuczną inteligencję pochodziły głównie z dziedziny informatyki, ale spotykane były także w innych dyscyplinach np. medycyny i inżynierii.

Prof. Strzelecki w swojej pracy zaznaczył także, że czasopisma nie zezwalają na wykorzystywanie sztucznej inteligencji do pisania prac. Dopuszczają jedynie wykorzystanie narzędzi opartych na AI do korekty językowej tekstu i tłumaczenia, przy założeniu, że autor bierze za ten proces pełną odpowiedzialność i ujawni tę informację.

Zagłębiając się w publikację naukowca z Uniwersytetu Ekonomicznego w Katowicach, możemy też odnaleźć informacje, że w niektórych przypadkach autorzy, których wpadki zostały wyłapane przez dziennikarzy, składali wyjaśnienia, tłumacząc się błędnym tłumaczeniem przez algorytm. Zdarzały się jednak i takie, które były wycofywane i usuwane z bazy.

Czy używanie sztucznej inteligencji do pisania artykułów naukowych jest powszechnym problemem?

W 2023 r. baza danych Scopus zawierała 2 511 962 publikacje naukowe o statusie artykułu. Badania przeprowadzone przez prof. Strzeleckiego ujawniły 89 pisanych z wykorzystaniem ChataGPT, co stanowi tylko niewielki ułamek całości.

Warto zauważyć, że w roku 2023 baza danych Scopus zawierała 2 511 962 publikacje naukowe o statusie artykułu. Jeśli porównamy to z liczbą 89 artykułów znalezionych w czasopismach indeksowanych w bazie danych Scopus, omawiany problem stanowi tylko 0,000035 proc. całości, co jest wartością mniejszą niż margines błędu. Podobny wynik (0,000035 proc.) uzyskano dla 80 artykułów znalezionych w czasopismach indeksowanych w Web of Science, które zgłosiły 2 291 309 publikacji o statusie artykułu w roku 2023.

Czy więc należy uznać, że problemu w ogóle nie ma? W żadnym wypadku. - Niemniej jednak potencjalny wpływ nawet niewielkiego odsetka artykułów zawierających treści generowane przez AI, zwłaszcza pod względem potencjalnych implikacji dla zaufania do publikacji naukowych, może być negatywny – pisze polski badacz. Mowa nie o podrzędnych czasopismach, a o czołówce wydawców ze wskaźnikami jakości, takimi jak Impact Factor i CiteScore: Elsevier, Springer, Wiley i Sage.

Wyobraźmy sobie sytuację, w której ChatGPT został wykorzystany (bez wnikliwego sprawdzenia efektów) do przygotowania publikacji naukowej z dziedziny medycyny. Został opublikowany w renomowanym czasopiśmie i następnie jest cytowany przez kolejnych naukowców, przez co potencjalnie błędna informacja może pójść dalej w świat i być wykorzystana do leczenia chorych. Czy tu potrzebujemy setek artykułów, żeby stwierdzić problem? Moim zdaniem wystarczy jeden, który zyska większy rozgłos. W dziedzinie nauk o środowisku i zmianach klimatu, które są śledzone, także łatwo o dezinformację.

Źródła: Strzelecki, A. (2025), ‘As of my last knowledge update’: How is content generated by ChatGPT infiltrating scientific papers published in premier journals?. Learned Publishing, 38: e1650. https://doi.org/10.1002/leap.1650; naukawpolsce.pl