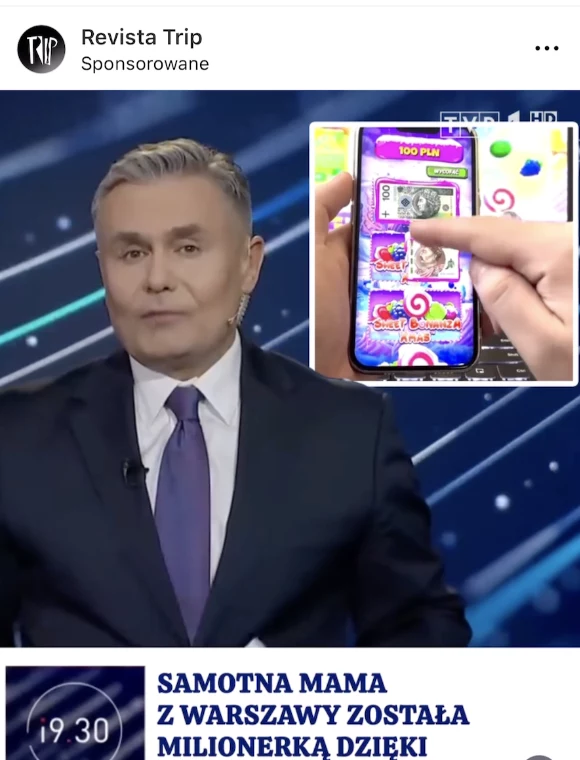

Oszuści podszywają się pod TVP i i9:30. W tle niebezpieczna aplikacja

Wizerunek TVP oraz programu i9:30 i jego prowadzącego został wykorzystany przez oszustów. Stworzono wideo deepfake z użyciem sztucznej inteligencji, w którym podszyto się pod Marka Czyża oraz przy okazji także bank PKO BP. Głównym celem nagrania jest promowanie niebezpiecznej aplikacji do hazardu.

Nie tak dawno wspominaliśmy wam, że w YouTube znaleziono fałszywą reklamę, gdzie wykorzystano wizerunek prezydenta Polski. Teraz dowiadujemy się o nowym nagraniu deepfake, gdzie oszuści postanowili podszyć się pod stację TVP oraz program i9:30 z Markiem Czyżem w roli głównej. Celem oszustwa jest promowanie niebezpiecznej aplikacji.

Oszuści wykorzystali wizerunki i9:30 oraz TVP w nagraniu deepfake

Nagranie krążące po sieci zostało stworzone z wykorzystaniem sztucznej inteligencji. Oszuści wykorzystali bezprawnie logo TVP oraz programu i9:30, który zastąpił poprzednie Wiadomości. W filmie pojawia się prowadzący Marek Czyż, ale tak naprawdę wypowiadane w materiale słowa nie są jego. Zostały dodane z użyciem AI.

Materiał krąży po serwisach społecznościowych i wykorzystano w nim również wizerunki banku PKO BP oraz youtubera Mr Beast. Film pokazuje historię kobiety z Warszawy, która została milionerką. Stało się to możliwe z użyciem specjalnej aplikacji, do której instalacji w deepfake'u zachęca Marek Czyż. Oczywiście jest to nieprawdą i wideo ma skusić ofiary do pobrania niebezpiecznej aplikacji hazardowej, która nie pomoże się wzbogacić, a raczej stracić pieniądze.

Film prawdopodobnie został stworzony przez oszustów z zagranicy

Na pierwszy rzut oka wideo może sprawiać wrażenie, że powstało w Polsce. Można jednak znaleźć tu pewne niedociągnięcia, które pozwalają nam sugerować, że deepfake opracowano jednak za granicą. Na przykład wspomniana Polka ma na imię Hanah i w jej wypowiedziach oraz na zrzutach ekranowych pojawiają się pewne błędy.

Trzeba jednak przyznać, że wypowiedzi Marka Czyża w filmie brzmią dosyć wiarygodnie. Niestety sztuczna inteligencja pozwala obecnie na tworzenie coraz lepszych materiałów z deepfake i to stanowi duże zagrożenie. Wiele osób po obejrzeniu takiego nagrania może dać się nabrać i to będzie wiązało się z późniejszymi konsekwencjami, na przykład w postaci utraty oszczędności życia.

Polecamy na Antyweb: Hity z Xboksa mogą trafić na PS5! Microsoft rezygnuje z wyłączności?

Celem przestępców jest wzbudzenie zaufania

Oszuści działają w taki sposób, że wśród własnych ofiar chcą wzbudzić zaufanie. Nagrania typu deepfake idealnie się do tego nadają, bo prezentują zazwyczaj ludzi znanych oraz obdarzonych zaufaniem. Niestety nierzadko może być tak, że przestępcy po prostu wykorzystują ich wizerunki do osiągnięcia własnych celów.

Jeszcze kilka lat temu demaskowanie sfabrykowanych filmów i obrazów było stosunkowo proste, ale z biegiem czasu stało się znacznie trudniejsze. Obecnie coraz trudniej stwierdzić, czy dany materiał jest wytworem AI. Narzędzia do tworzenia materiałów deepfake są na wyciągnięcie ręki dla każdego cyberprzestępcy. Bardzo szybko rozwija się technologia związana z klonowaniem głosu. Oszustwa z wykorzystaniem wizerunku znanych osób to jeden wątek, a drugim jest możliwość fabrykowania nagrań z udziałem użytkowników prywatnych. Dostarczanie materiałów do nagrań deepfake to bowiem zagrożenie związanie z korzystaniem z mediów społecznościowych, o którym rzadko myślimy.