Moralne dylematy sztucznej inteligencji, czyli niedoskonała broń przyszłości

Wielu ekspertów militarnych od lat przekonywało, że współczesne konflikty zbrojne rozegrają się poza klasycznym polem bitwy albo z użyciem robotów i sztucznej inteligencji, tymczasem obrazy z Ukrainy zaatakowanej przez Rosję wyglądają... zaskakująco znajomo. A może tylko się nam wydaje?

Sztuczna inteligencja jest wszędzie i coraz chętniej korzystamy z oferowanych przez nią możliwości, zarówno w codziennych aktywnościach, jak i bardzo zaawansowanych zastosowaniach naukowych. Polubiliśmy cyfrowych asystentów, spersonalizowane propozycje tytułów do obejrzenia na Netflixie czy sklepy internetowe, które tak dobrze znają nasz gust.

Naukowcy w końcu mogą zaś odpowiedzieć na pytania, które od lat spędzały im sen z powiek - wystarczy spojrzeć na DeepMind, które rozwiązało istniejący od 50 lat problem w zakresie zwijania białek, poprawia skuteczność prognoz pogody, kontroluje fuzję jądrową czy uzupełnia brakujące fragmenty starożytnych tekstów i podaje miejsce ich powstania.

Zafascynowani możliwościami sztucznej inteligenci często zapominamy jednak, że AI to również systemy rozpoznawania twarzy i aplikacje szpiegujące pokroju Pegasusa, poważnie zagrażające naszej wolności i prywatności czy technologia DeepFake, która służy już nie tylko do tworzenia filmów dla dorosłych ze znanymi hollywoodzkimi gwiazdami, ale i prowadzenia działalności przestępczej. Do tego sztuczną inteligencją od lat interesują się specjaliści od wojskowości, którzy upatrują w niej broni na miarę XXI wieku i jak wskazują ostatnie doniesienia z Ukrainy... najpewniej już taką została.

Hawking i Musk ostrzegali już dawno temu

Gdybyśmy tylko posłuchali głosów rozsądku... Stephen Hawking, Elon Musk (jeszcze przed autonomicznymi Teslami!) i inni naukowcy już w 2015 roku ostrzegali, że niekontrolowany rozwój sztucznej inteligencji może być poważnym zagrożeniem dla ludzkości. Wskazywali, że należy powołać organizacje, które będą kontrolowały prace nad AI i potencjalne niebezpieczeństwo, by w porę zapobiec... kresowi gatunku ludzkiego! Tak, jeszcze kilka lat temu naukowcy poważnie obawiali się możliwości sztucznej inteligencji, dlatego też wystosowali i podpisali list otwarty, który miał być gwarancją tego, że rozwojowi sztucznej inteligencji będzie przyświecał tylko jeden cel, a mianowicie dobro ludzkości.

I choć “bunt maszyn" w stylu Terminatora nie jest pierwszym, co przychodzi nam w tej sytuacji do głowy, to Unia Europejska na wszelki wypadek opublikowała w 2019 roku regulacje dotyczące etyki sztucznej inteligencji. To raczej wskazówki niż oficjalne przepisy, ale dokument wskazuje na 7 wytycznych, wśród których znajdziemy choćby takie zapisy:

- systemy sztucznej inteligencji powinny dążyć do sprawiedliwych społeczeństw, wspierając ludzkie interesy i fundamentalne prawa oraz nie zmniejszać i ograniczać ludzkiej autonomii;

- obywatele powinni mieć pełną kontrolę nad swoimi danymi, a dane ich dotyczące nie mogą być wykorzystywane, żeby ich dyskryminować czy krzywdzić;

- wszystkie systemy AI muszą być możliwe do zidentyfikowania;

- systemy AI powinny być wykorzystywane do wzmacniania pozytywnych zmian społecznych, odpowiedzialności ekologicznej i szanse na przetrwanie;

- trzeba zastosować odpowiednie mechanizmy i wziąć odpowiedzialność za wszystkie systemy AI.

Wydaje się jednak, że skupiając się na potencjalnych zaletach sztucznej inteligencji, szybko zapomnieliśmy o zagrożeniach, jakie niesie ze sobą w rękach nieodpowiednich osób. Postulaty naukowców i moralne rozterki poszły w odstawkę, tymczasem zagrożenie jest naprawdę poważne i już niebawem możemy się o tym boleśnie przekonać. O czym mowa?

Niebezpieczne narzędzie do produkcji broni

Przykładów nie trzeba szukać daleko, bo niecałe 2 tygodnie temu firma Collaborations Pharmaceuticals opublikowała wyniki swojego niepokojącego badania, w którym postanowiła sprawdzić, co się wydarzy, kiedy AI dostanie możliwość analizy i pracy na toksycznych cząsteczkach. Efekt? Chociaż nie taki był plan, to w ciągu zaledwie 6 godzin pracy AI wskazało ok. 40 tysięcy związków potencjalnie możliwych do zastosowania jako broń biologiczna i chemiczna.

Naukowcy podkreślali, że długo zastanawiali się, czy powinni opublikować wyniki swoich badań, by nie dostarczać inspiracji niewłaściwym osobom, bo mamy do czynienia z potencjalnym nadużyciem, którego wykonanie nie zajęło na dodatek zbyt wiele czasu. Szczególnie że jak wiemy po innym z eksperymentów, w którym sztuczna inteligencja Megatron od Nvidii została wytrenowana na całych zasobach Wikipedii oraz milionach artykułów, aby odpowiedzieć na pytanie o motywację swojego postępowania, AI sama w sobie nigdy nie będzie działać etycznie i efekty jej działania zawsze zależeć będą od człowieka.

Sztuczna inteligencja nigdy nie będzie etyczna. Jest tylko narzędziem i jak każde narzędzie jest wykorzystywana do czynienia dobra lub zła. Nie istnieje coś takiego jak dobra czy zła sztuczna inteligencja, istnieją wyłącznie dobrzy i źli ludzie

Oznacza to, że tam gdzie jedni widzą szansę na produkcję leków oraz metody leczenia trapiących nas chorób, inni widzą narzędzie produkcji broni masowej zagłady. Co zatem zrobić, zabronić stosowania AI w każdym celu na wszelki wypadek?

Deepfake w służbie wojennego kłamstwa

Mało? W takim razie kolejny przykład, którego próbki mogliśmy oglądać jakiś czas temu w kontekście działań wojennych w Ukrainie. Najpierw w sieci pojawił się deepfake z Władimirem Putinem, który ogłasza zwycięstwo Rosji nad Ukrainą, a następnie kolejny materiał, w którym Wołodymyr Zełeński rzekomo informuje swoich obywateli o złożeniu broni przez armię ukraińską.

I choć czasem deepfake można rozpoznać już na pierwszy rzut oka, to trenowana sztuczna inteligencja jest coraz lepsza w tworzeniu takich treści i część z nich wygląda naprawdę realistycznie.

To pozwala podszywać się pod inne osoby, rozsiewać nieprawdziwe informacje i w ten sposób manipulować opinią publiczną, co może przynieść fatalne w skutkach konsekwencje, np. faktyczne poddanie się armii, która powinna walczyć (bo wydaje się jej, że przyjmuje rozkazy od swojego dowódcy) czy wręcz przeciwnie, kontynuowanie działań wojennych, kiedy powinny zostać zakończone. Amerykańska Agencja Wywiadowcza (CIA) ostrzegała, że tego typu nagrania mogą wręcz doprowadzić do wybuchu wojny czy użycia broni jądrowej.

Broń samodzielnie decydująca o życiu i śmierci

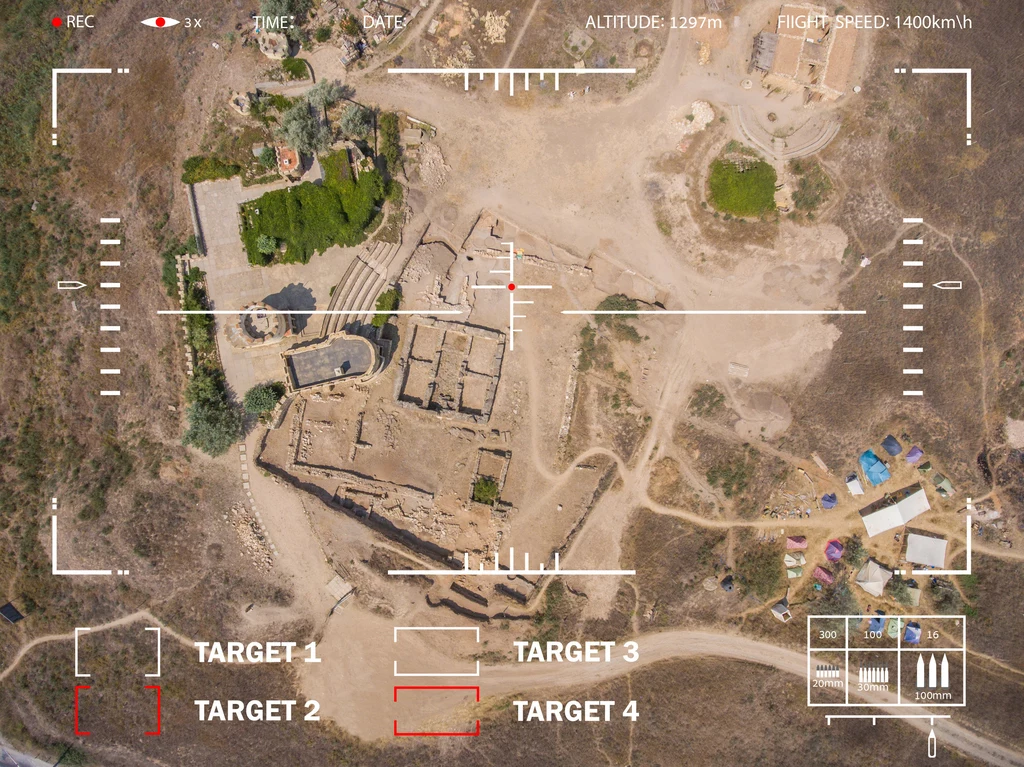

Na koniec został najtrudniejszy wątek, który budzi zdecydowanie najwięcej wątpliwości moralnych, a mianowicie sztuczna inteligencja samodzielnie decydująca o życiu i śmierci na polu bitwy. A mowa o autonomicznych systemach bojowych (AWS), czyli takich potrafiących samodzielnie zlokalizować i zidentyfikować cel, a następnie otworzyć ogień bez jakiegokolwiek nadzoru ze strony ludzkiego operatora. Brzmi przerażająco? Zdecydowanie i wcale nie chodzi o odległą przyszłość, bo chociaż jeszcze niedawno wszystkie czynności wojskowe podczas konfliktu zbrojnego, w tym przysłowiowe pociągnięcie za spust, faktycznie zależały od człowieka, to pojawiają się uzasadnione obawy, że ta granica została już przekroczona.

Ludzie powinni zachować odpowiedni poziom kontroli oraz być odpowiedzialni za rozwój, rozmieszczenie, wykorzystanie i skutki działania sztucznej inteligencji w wojsku.

Tyle możemy dowiedzieć się z zasad etyki wojskowej AI przyjętych przez Defense Innovation Advisory Board, czyli niezależnej instytucji doradczej utworzonej w 2016 r. w celu wprowadzenia innowacji technologicznych Doliny Krzemowej do amerykańskiej wojskowości. Oznacza to, że w założeniach autonomiczne systemy bojowe w ogóle nie powinny istnieć i są ku temu konkretne przyczyny.

Ich zwolennicy przekonują wprawdzie, że eliminują błąd ludzki wywołany choćby stresem czy zmęczeniem, a do tego są odporne na ból, tortury czy zespół stresu pourazowego, ale pomijają przy tym wiele problemów i moralnych wątpliwości. Jakich? Systemy bojowe oparte na sztucznej inteligencji są odporne na ból i tortury, ale nie są odporne na hakowanie i błędy w oprogramowaniu - oznacza to, że utalentowani hakerzy mogą przejąć nad nimi kontrolę i zmodyfikować ich wytyczne (nie wspominając nawet o niecelowych błędach).

Część specjalistów na chłodno podchodzących do AI w wojskowości wskazuje również na fakt, że systemy rozpoznawania twarzy, z których autonomiczne systemy bojowe muszą korzystać do identyfikacji celów, są podatne na uprzedzenia rasowe czy płciowe, co może prowadzić do dyskryminacji i wielu pomyłek.

Co więcej, biorąc pod uwagę, że nie grożą im z tego tytułu żadne konsekwencje prawne, a nawet moralne, bo nie mają przecież sumienia, zabijanie może im przychodzić po prostu zbyt łatwo.

Czy naprawdę jesteśmy gotowi oddać decyzję o życiu i śmierci w ręce wciąż niedoskonałego oprogramowania? Niestety na to wygląda, bo choć do tej pory oficjalnie nie udało się zgromadzić dowodów na użycie tego rodzaju broni, to istnieją uzasadnione podejrzenia jej wykorzystania w czasie wojny domowej w Libii, a także... w Ukrainie, gdzie Rosjanie posłali drony-kamikadze ZALA Areo KUB-BLA, których oficjalna specyfikacja przewiduje w pełni autonomiczne działanie. Mówiąc krótko, sztuczna inteligencja to bez wątpienia broń przyszłości, pytanie tylko, czy ta przyszłość nie nadchodzi przypadkiem zdecydowanie zbyt szybko.