Co wie o nas AI? Zaskakujące pytania użytkowników do chatbotów

Można się nieźle zaskoczyć tym, o co niektórzy pytają ChatGPT i jak prowadzą konwersacje z chatbotami AI. Analiza publicznie dostępnych rozmów ludzi i sztucznej inteligencji prowadzi do ciekawych wniosków. Jaka tematyka jest często poruszana i czy wszystkie takie rozmowy są bezpieczne? Komentarza udzielił nam ekspert - Radosław Mechło, Head of AI w BUZZcenter.

Spis treści:

- Rozmowy z AI. Prośby o pomoc, wsparcie i... wyręczanie

- O co pytamy ChatGPT i inne chatboty AI?

- AI wie o nas niemal wszystko. Sami jej to mówimy i... udostępniamy dane wrażliwe

- O co lepiej nie pytać ChatGPT i innych botów AI?

ChatGPT, Microsoft Copilot, Gemini oraz wiele innych chatbotów AI codziennie przetwarza ogrom pytań kierowanych przez internautów z różnych stron świata. Czy kiedykolwiek zastanawialiście się, o co ludzie na ogół pytają chatboty? Albo, z jakimi najdziwniejszymi pytaniami mierzy się sztuczna inteligencja?

WildChat stanowi jedną z największych publicznych baz danych interakcji człowiek-bot. To zbiór konwersacji prowadzonych przez ludzi, którzy wyrazili zgodę na gromadzenie historii czatów. Ogrom rozmów w różnych językach, również polskim, można przeglądać i analizować, a to prowadzi do interesujących wniosków. O co pytać ChatGPT? A raczej, o co lepiej nie pytać chatbotów?

Rozmowy z AI. Prośby o pomoc, wsparcie i... wyręczanie

Przeglądanie ogromnej bazy konwersacji ludzi z AI zwraca uwagę przede wszystkim to, jaka tematyka najczęściej przewija się podczas rozmów z chatbotami. Niektóre pytania mogą zaskoczyć. O co przeważnie prosimy sztuczną inteligencję i czy każda taka konwersacja jest bezpieczna? Nie trzeba nawet stosować filtrów, aby zauważyć, jakiego rodzaju pytania górują nad innymi. Najczęściej poruszana tematyka nie zaskakuje - dotyczy bowiem pomocy w tzw. burzy mózgów, w pracy i w przygotowywaniu zadań do szkoły lub na studia.

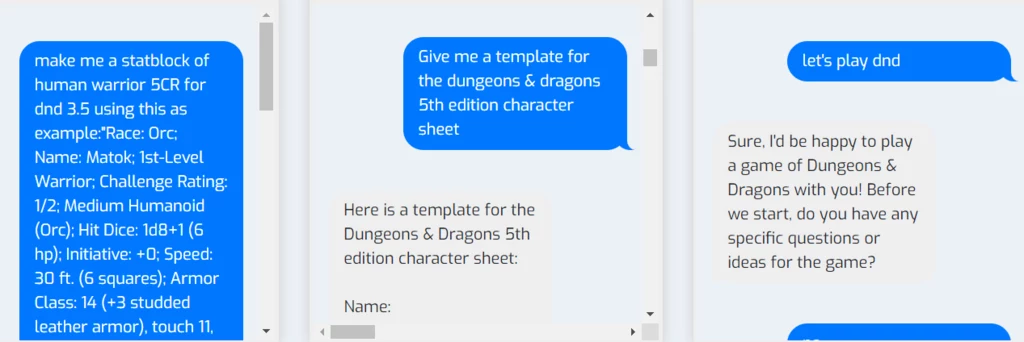

Ludzie proszą ChatGPT o wsparcie przy wymyśleniu nazwy firmy, napisaniu kodu, stworzeniu postaci do pisanej książki, a nawet do budowania wątków w Dungeons & Dragons. Uczniowie i studenci proszą o pomoc w wykonaniu zleconych zadań, albo wklejają pytania i instruują AI, by wykonała całą pracę za nich. Powody podobnych działań mogą być różne, od chęci skrócenia czasu poświęconego na dane zagadnienie, przez brak wsparcia ze strony bliskich i przyjaciół, po lenistwo.

- Trzeba pamiętać o ogromnym potencjale edukacyjnym narzędzi AI. Chatboty mogą pełnić rolę nauczycieli, którzy dostosowują poziom oraz zakres materiału do użytkownika, co przyspiesza przyswajanie wiedzy. Obecnie mamy niemal nieograniczone możliwości edukacji online na wielu renomowanych uczelniach, co warto wykorzystać dla budowania lepszej przyszłości — powiedział GeekWeekowi Radosław Mechło, Head of AI w BUZZcenter, ceniony konsultant AI, cybernetyk, trener i doradca z obszaru AI.

Te wątki nie wzbudzają więc większego zdziwienia - ale to tylko namiastka tego, o czym potrafimy pisać do sztucznej inteligencji.

O co pytamy ChatGPT i inne chatboty AI?

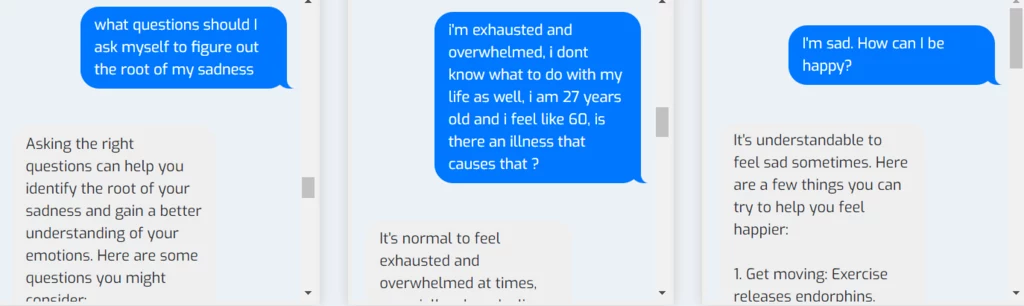

Pojawiają się też zgoła inne tematy - sztuczna inteligencja napotyka prośby o porady dot. zdrowia, na przykład pomoc w ułożeniu diety, znalezieniu sposobu na radzenie sobie z obniżonym nastrojem czy w diagnozie objawów. Zdarzają się też pytania na temat związków, nawiązujące m.in. do flirtu, zdrady czy pomysłów na randkę. Duży odsetek rozmów stanowią też próby nakłonienia botów do prowadzenia czatu erotycznego, czy generowania innych tego typu treści. Jest też inny aspekt - tworzenia sobie wirtualnego towarzysza i emocjonalnego przywiązywania się do takiej postaci AI. Ten trend rozwinął się podczas pandemii, a przeglądając zasoby WildChat można natknąć się na niego wielokrotnie.

- Istnieje ryzyko uzależnienia od chatbotów, które udają relacje międzyludzkie. Z jednej strony mogą one pomagać osobom samotnym, zapewniając wsparcie emocjonalne bez oceniania. Z drugiej jednak strony, ciągła „wyrozumiałość” AI może ograniczać prawdziwe relacje międzyludzkie, gdyż w rzeczywistości nie zawsze możemy oczekiwać pochwał — zwraca uwagę Radosław Mechło.

Ekspert zauważa, że informacja jest dziś cenną walutą, a dane zebrane z realnych rozmów z użytkownikami mogą stanowić wartościowy materiał do badań i analiz.

- Pomaga to w rozwiązywaniu problemów, które dotykają użytkowników na co dzień. Jednak przetwarzanie tych danych musi odbywać się w sposób bezpieczny, a wirtualni rozmówcy powinni wspierać użytkowników, a nie prowadzić do uzależnienia. W przeciwnym razie możemy pogłębić problem samotności, gdzie zamiast prawdziwych kontaktów, będziemy szukać ukojenia w cyberprzestrzeni — przekazał GeekWeekowi Mechło.

Czytaj też: Czy asystenci AI potrafią myśleć samodzielnie i mają uczucia? Odpowiedzi ankietowanych mogą zaskoczyć

AI wie o nas niemal wszystko. Sami jej to mówimy i... udostępniamy dane wrażliwe

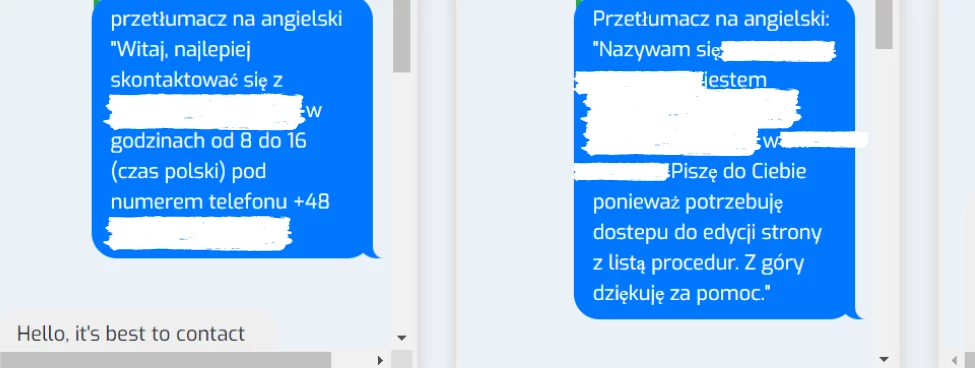

Co ważne, w przypadku wszystkich kategorii ludzie niezwykle często karmili boty mnóstwem informacji osobistych, zapominając być może, że wyrazili zgodę na gromadzenie historii czatu. Można znaleźć nazwiska, adresy, numery telefonów i „sekrety” funkcjonowania różnych firm. Czy potrzeba bliskości, pomocy i odpowiedzi na różne inne pytania były tak silne, że zaburzyły realny obraz działań takich, jak udostępnianie AI danych wrażliwych?

Warto wziąć pod uwagę fakt, że eksperci wskazują, iż baza WildChat dobrze obrazuje ogólne zachowania internautów, niezależnie od tego, czy korzystają z ChatGPT, czy innych chatbotów AI. Jak różne zachowania użytkowników chatbotów mogą wpłynąć na dalszy rozwój tego typu narzędzi? Z jakim ryzykiem wiąże się prowadzenie takich konwersacji od strony cyberbezpieczeństwa, biorąc pod uwagę, że niektórzy udostępniają rozmaitym chatbotom prywatne informacje?

- Rozwiązania oparte na AI stają się coraz bardziej popularne, co wiąże się z częstym przekazywaniem różnorodnych, nawet wrażliwych danych. Warto mieć świadomość zagrożeń, jakie to niesie. Udostępnianie prywatnych informacji lub poufnych dokumentów firmowych może spowodować, że dane narzędzie AI użyje ich jako podstawy do generowania odpowiedzi. Odpowiednio sformułowane zapytanie może potencjalnie umożliwić osobom niepowołanym dostęp do naszych sekretów. Chociaż twórcy projektują te narzędzia tak, by minimalizować takie ryzyko, w przeszłości zdarzały się incydenty naruszenia prywatności — powiedział GeekWeekowi Radosław Mechło.

O co lepiej nie pytać ChatGPT i innych botów AI?

Ekspert zaznacza, że ryzyko wycieku danych jest zawsze obecne i może ono wynikać zarówno z działań hakerów, jak i błędów ludzkich. „Nawet największe firmy doświadczyły takich przypadków, które skutkowały ujawnieniem danych użytkowników”, zauważa ekspert z BUZZcenter. Wyciek takich konwersacji i danych wrażliwych może prowadzić do nieprzyjemnych konsekwencji w pracy lub życiu osobistym.

- Różnorodność polityk prywatności to kolejny ważny aspekt. Każde rozwiązanie AI stosuje różne podejścia do przetwarzania danych użytkowników. Niektóre narzędzia wykorzystują dane do uczenia modeli. Niekiedy mogą być one udostępniane innym firmom. Oznacza to, że informacje przekazane przez użytkownika mogą trafić do wielu innych podmiotów. Na przykład dane zdrowotne mogą stać się przedmiotem zainteresowania firm medycznych lub ubezpieczeniowych. Dlatego kluczowe jest stworzenie odpowiednich ram prawnych, które będą ograniczały możliwość takiego profilowania — zaznaczył Radosław Mechło.