Język polski najlepszy w testach sztucznej inteligencji

Sztuczna inteligencja, o której najwięcej się dziś mówi, to tzw. duże modele językowe (LLMs). Na nich opierają się ChatGPT, Copilot i Gemini. To oprogramowanie wytrenowane głównie do pracy z tekstem. AI ma już bardzo dobre zrozumienie języka naturalnego ludzi, jednak wykazuje pewne różnice w poszczególnych jego językach. Ku zaskoczeniu wielu osób nowe badanie pokazało, że AI najlepiej rozumie... język polski.

Spis treści:

- Sztuczna inteligencja coraz lepsza w rozumieniu języków

- Język polski najlepszy dla AI

- Nadreprezentacja angielskich treści w internecie?

Sztuczna inteligencja coraz lepsza w rozumieniu języków

ChatGPT, Copilot, Gemini czy Grok to aplikacje oparte na dużych modelach językowych (ang. Large Language Models - LLMs), specjalnych modelach sztucznej inteligencji zdolnej do pracy z tekstem w języku naturalnym - takim, jakim ludzie posługują się na co dzień. Oznacza to, że oprogramowanie potrafi interpretować komunikaty wyrażane dość swobodnie, także w mowie potocznej, tak jak rozmawiają ludzie. Nie muszą to być sztywne frazy bądź polecenia pisane kodem programistycznym.

Zdolności językowe AI rosły wraz z czasem. Duże zmiany odnotowano w poprzedniej dekadzie (2010-2020), gdy wyszukiwarki internetowe Google i Bing zaczęły dużo lepiej rozumieć intencje użytkownika, wnioskując je z fraz wyszukiwania, nawet gdy nie zawierały one najważniejszych słów kluczowych. Podobnie duże postępy zaliczyły translatory Google i Microsoftu, gdy tłumaczenie maszynowe oparto na sieciach neuronowych. Miało to miejsce jeszcze przed wielkim boomem AI, który nastąpił dopiero w 2023 roku, wraz z upowszechnieniem się ChatuGPT, a następnie pozostałych czatbotów.

Co prawda czatboty istniały już wcześniej, ale były one dużo bardziej prymitywne. Wiele z nich, np. Cortana w Windows, w ogóle nie obsługiwało języka polskiego. Dziś to już standard. Praktycznie wszystkie wiodące aplikacje konwersacyjnej AI doskonale rozumieją język polski, podobnie jak wiele innych języków innych niż angielski. Co więcej, zaliczyły one w ostatnim czasie tak duży postęp, że według ekspertów Polacy znaleźli się wręcz na uprzywilejowanej pozycji.

Język polski najlepszy dla AI

Badacze sztucznej inteligencji z University of Maryland oraz Microsoft opracowali narzędzie do oceniania jej zdolności językowych przy przetwarzaniu dłuższych tekstów w 26 różnych językach. Benchmark nosi nazwę ONERULER i stawia przed modelami siedem zadań testujących ich umiejętności wyszukiwania i agregacji danych, w tym zadania typu "szukanie igły w stogu siana", które dopuszczają możliwość, że igły tej nie ma.

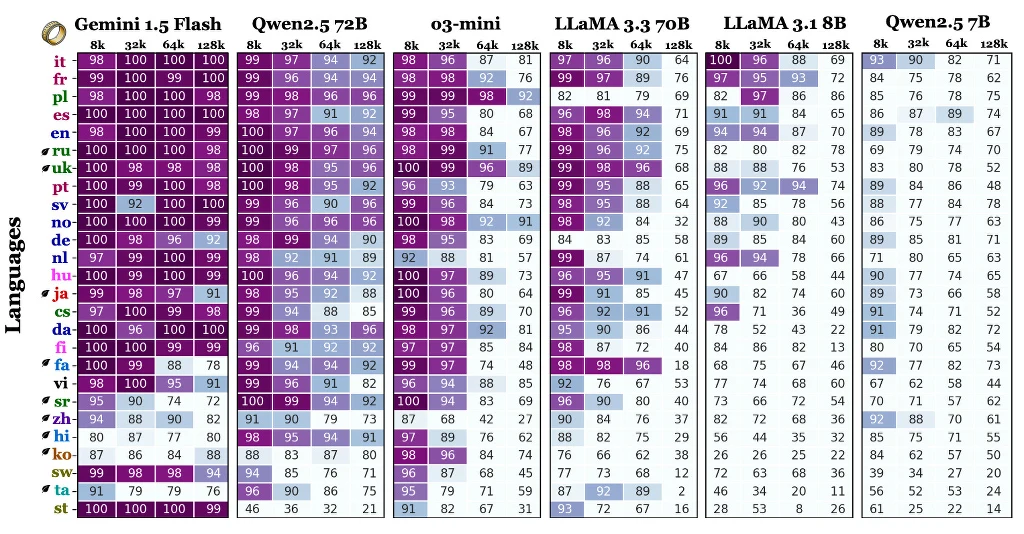

W badaniu, na temat którego ukazał się artykuł naukowy (na razie jako preprint, czyli przed publikacją w czasopiśmie) przetestowano popularne dziś modele LLM różnych rozmiarów, wliczając w to o3-mini-high od OpenAI, Gemini 1.5 Flash od Google, Qwen 2.5 (7B i 72B), oraz Llama 3.1 (8B) i Llama 3.3 (70B) od Meta AI. W tabeli możecie prześledzić, jak radzą sobie one z poszczególnymi językami w benchmarku.

Wyniki testu zaskoczyły badaczy. "Niespodziewanie angielski nie był najlepiej radzącym sobie językiem w zadaniach z długim kontekstem (miejsce 6. spośród 26), a najlepiej wypadł polski" - czytamy w abstrakcie badania. Jak widać w tabeli, każdy z modeli podzielono na cztery długości kontekstu (8k, 32k, 64k i 128k), co oznacza zadania o różnej długości. Język polski był szczególnie dobrze rozumiany przez modele Gemini 1.5 Flash, Qwen 2.5 72B i o3-mini, ale już nieco słabiej przez oba modele z serii Llama oraz wariant Qwen z mniejszą liczbą parametrów.

W ujęciu ogólnym badane modele sztucznej inteligencji wykazały najlepsze zrozumienie języków: polskiego (88%), francuskiego (87%), włoskiego (86%), hiszpańskiego (85%), rosyjskiego (84%), angielskiego (83,9%), ukraińskiego (83,5%), portugalskiego (82%), niemieckiego (81%) i niderlandzkiego (80%).

Nadreprezentacja angielskich treści w internecie?

Ten niezwykły talent sztucznej inteligencji do rozumienia języka polskiego wydaje się wręcz sprzeczny z tzw. zdrowym rozsądkiem i dotychczasową wiedzą. Eksperci zwracali już bowiem wcześniej uwagę, że duże modele językowe trenowane są na ogólnodostępnych zestawach danych, często np. na tekstach z Wikipedii czy Reddita (o ile licencja na to pozwala), a lwia część tych danych jest w języku angielskim. Panuje tu ogromna dysproporcja. Wikipedia anglojęzyczna jest ponad 4-krotnie większa od polskiej (odpowiednio 6,961,391 i 1,649,832 artykułów).

Co więcej, ok. 25-50% treści w internecie jest w języku angielskim, mimo że jest to język ojczysty zaledwie dla 4,6-5% światowej populacji. Jako że jest to język międzynarodowy, praktycznie tradycją było, że był to pierwszy język w oprogramowaniu i sprzęcie komputerowym, internecie, nauce i sztucznej inteligencji. Rozwój technologii AI sprawił jednak, że stała się ona bardziej inkluzywna i dostępna dla użytkowników innych języków - w tym dla Polaków.

"Jak wynika z analiz, jest najbardziej precyzyjny pod względem wydawania poleceń sztucznej inteligencji. Dotychczas język polski powszechnie uznawano za jeden z najtrudniejszych do nauki. Jak się okazuje, kłopot z tym mają ludzie, ale nie AI" - skomentował Urząd Patentowy Rzeczypospolitej Polskiej na Facebooku. "Wnioski? Polski to najlepszy język do promptowania" - dodaje.

Czy przekłada się to na lepsze zrozumienie Polaków przez ChatGPT, Copilota, Gemini albo Groka? Niekoniecznie. Badanie nie przetestowało wszystkich modeli, które za nimi stoją. Przykładowo o3-mini nie jest domyślnym modelem w Copilocie i ChacieGPT (jest nim obecnie GPT-5), zaś w aplikacji Google Gemini działa jako domyślny model Gemini 2.5 Flash, czyli wyższa wersja. ONERULER jest jednak benchmarkiem na licencji Open Source, wydanym w GitHub, co pozwala każdemu zainteresowanemu przetestować poszczególne modele. Trzeba jednak pamiętać, że to tylko ustandaryzowany test. W praktyce zdolności językowe modeli mogą się wahać w niezaadresowanych przez niego scenariuszach.

Źródło: Yekyung Kim, Jenna Russell, Marzena Karpinska, Mohit Iyyer (2025). One ruler to measure them all: Benchmarking multilingual long-context language models. arXiv:2503.01996 [cs.CL]. https://doi.org/10.48550/arXiv.2503.01996