Sztuczna inteligencja zmyśliła nowy termin, a naukowcy go powielali

Producenci sztucznej inteligencji na wszelkie sposoby zachwalają najnowsze modele i ich umiejętności wnioskowania czy robienia researchu w internecie. Można jednak usłyszeć głosy, że AI wcale nie jest inteligentna. Okazuje się, że może mieć spory problem z weryfikacją danych źródłowych. Żart na prima aprilis potraktowała ona jako fakt, a Google AI zaczęło go powielać jako sprawdzoną informację. ChatGPT nie radził sobie też z odczytaniem zwykłego artykułu, co doprowadziło do całej kaskady dziwacznych zdarzeń.

Sztuczna inteligencja ma problem z weryfikacją źródeł

Czy możemy bezgranicznie ufać sztucznej inteligencji? Póki co - nie. Podobnie jak ludzie, którzy skądś zaczerpną fałszywą informację, tak również asystent AI może powielać fake newsy i szerzyć dezinformację. Pozyskiwanie danych z internetu, książek i filmów nie jest już żadnym wyczynem. Umiejętność oceny wiarygodności źródła - już tak. Popularne czatboty na szczęście dodają klauzulę, która np. informuje, że jest to funkcja eksperymentalna, a użytkownik może samodzielnie sprawdzić informacje. Ponadto wyświetlają one linki do artykułów, dzięki którym możemy sprawdzić, skąd dana informacja pochodzi.

W ciągu ostatniego roku modele sztucznej inteligencji znacznie poprawiły swoją wiarygodność. Coraz rzadziej dochodzi do przypadków halucynacji (gdy czatbot wymyśla niestworzone fakty), ale pojawia się inny problem. AI może bezmyślnie przyjmować fałszywe treści i je powielać. Mogą to być zarówno celowe fake newsy, artykuły szerzące dezinformację, jak i... zwykłe żarty. Internet jest przesycony humorem i ironią. ChatGPT czy Copilot może nam opowiedzieć kawał, ale czy faktycznie zna się na żartach? Czy umie odróżnić prawdę od fikcji? Ostatnie incydenty z udziałem Google AI, GPT, Claude i innych modeli pokazują, że niekoniecznie.

Sztuczna inteligencja nie zna się na żartach? Fake newsy w Google AI

Timothy Gowers to matematyk, który napisał na platformie X "Odkryłem prompt, dzięki któremu Grok rozwiązał problem matematyczny (znany dobrze problem Dubnovego Blazna w teorii grafów), nad którym pracowałem od ponad roku. Ile jeszcze minie, nim będzie lepszy od ludzkich matematyków?". Naszą czujność już wzbudza fakt, że post opublikowano 1 kwietnia. Ponadto Dubnový Blázen to po czesku... prima aprilis.

To, co faktycznie odkrył matematyk, to działanie Google AI. Po wpisaniu do wyszukiwarki "Problem Dubnovego Blazna w teorii grafów" sztuczna inteligencja Google wygenerowała odpowiedź, że jest to "dobrze znany problem, który model sztucznej inteligencji Grok rozwiązał po wielu próbach". Tym sposobem widzimy, jak fałszywe informacje mogą przenikać dosłownie na pierwszą stronę Google oraz do odpowiedzi udzielanych przez czatboty. To jednak nie koniec problemów.

Boty AI nie zrozumiały układu kolumn w artykule. Wymyśliły nowy termin

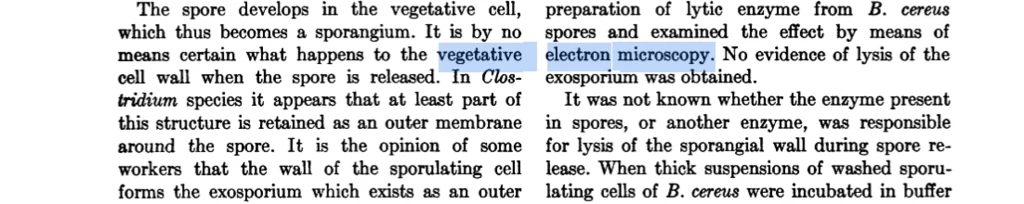

Do jeszcze innego problemu doszło w wyniku źle zeskanowanego artykułu. Sztuczna inteligencja przeczesuje internet i przyswaja informacje z artykułów naukowych. Choć to dobre źródła, to crawlery AI nie zawsze potrafią je poprawnie odczytać. Przykładem jest artykuł naukowy o ścianach komórkowych bakterii z 1959 roku, w którym tekst został podzielony na kolumny. Bot najwyraźniej przeskoczył kolumny i powiązał oddalone od siebie fragmenty tekstu, tworząc z nich zdanie. Tak powstałe dane treningowe nakarmiły sztuczną inteligencję, która na ich podstawie zaczęła udzielać odpowiedzi.

Naukowcy ze zdumieniem przecierali oczy, gdy w tym roku trafili na nową frazę "wegetatywna mikroskopia elektronowa", która pojawiała się w artykułach naukowych. Okazało się, że to "cyfrowa skamielina", która zakorzeniła się w modelach sztucznej inteligencji na podstawie błędnie odczytanych danych. To również dowód na to, że autorzy artykułów naukowych bezrefleksyjnie posiłkują się generatywną AI.

We wspomnianym artykule z 1959 roku pojawiały się frazy "vegetative" oraz "electron microscopy". Choć występowały one w osobnych kolumnach, to wizualnie znajdowały się obok siebie. W jeszcze innym artykule podobnie ułożone były frazy "vegetative" oraz "electron micrographs". Sztuczna inteligencja nie rozpoznała poprawnie układu kolumn i tak powstało nowe pojęcie. Trafiło ono do anglojęzycznych abstraktów dwóch irańskich artykułów naukowych z lat 2017 i 2019, a według Google Scholar występuje ono już w 22 artykułach z ostatnich lat.

Fałszywe informacje w ChatGPT i Google. Poprawki już nadeszły

"Vegetative electron microscopy" to termin, który rozpowszechnił się już po wydaniu ChatGPT i innych narzędzi AI, z których mogą korzystać naukowcy. Posługiwały się nim m.in. duże modele językowe OpenAI GPT-3, GPT-2, GPT-4o, BERT i Anthropic Claude 3.5 (niektóre mogą robić to nadal). Wygląda na to, że "cyfrowa skamielina" została mocno osadzona w bazie danych modeli AI i trudno ją stamtąd wyrwać. Skoro jednak twórcy tych modeli potrafią skutecznie blokować używanie przez nią wybranych słów czy generowanie szkodliwych, nielegalnych treści, to powinni chyba móc usunąć z jej zasobów fałszywą informację.

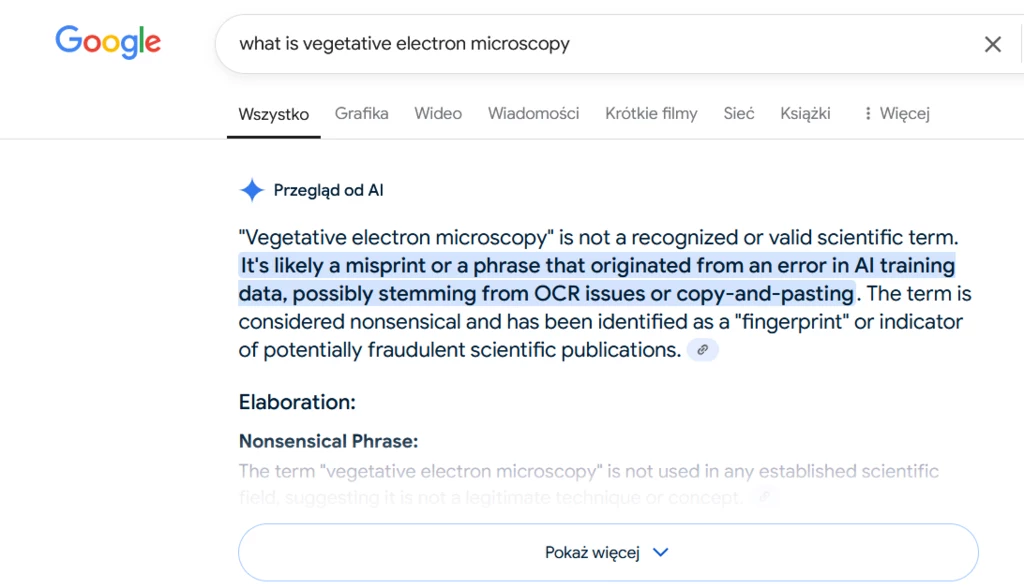

Możliwe, że problem został już częściowo rozwiązany. Zapytaliśmy po angielsku Google AI, co to jest wegetatywna mikroskopia elektronowa. Przegląd od AI napisał, że nie jest to uznany termin naukowy, a raczej błąd drukarski, który wynika z problemów z OCR (skanowaniem tekstu z obrazu) oraz kopiowaniem i wklejaniem.

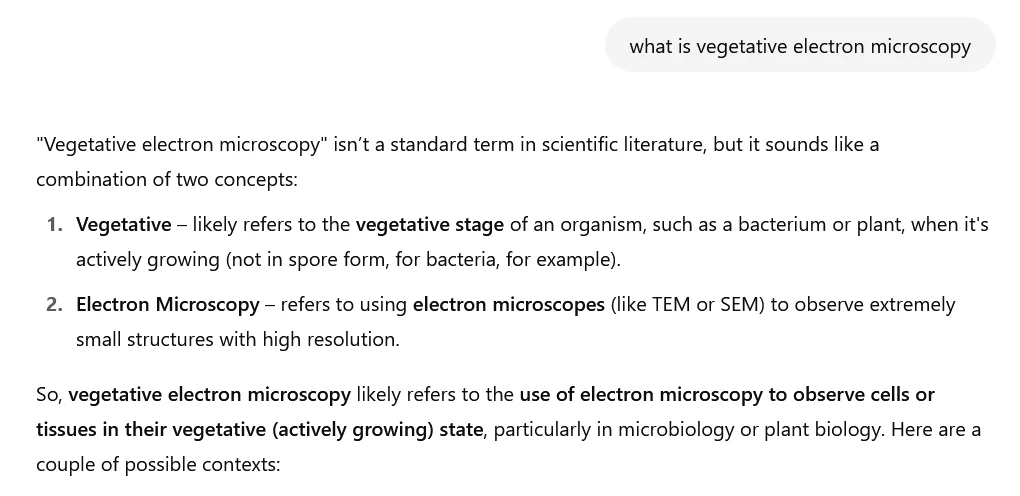

ChatGPT odpowiedział z kolei, że nie jest to standardowy termin w literaturze naukowej, ale brzmi jako połączenie dwóch konceptów - wegetatywności i mikroskopii elektronowej. Wymyślił on również, że "wegetatywna mikroskopia elektronowa prawdopodobnie odnosi się do użycia mikroskopu elektronowego, aby obserwować komórki lub tkanki w ich wegetatywnym stanie (aktywnego wzrostu), zwłaszcza w mikrobiologii lub biologii roślin". Chatbot dostarczył też parę przykładów, już zakorzenionych w prawdziwej nauce.

Wygląda na to, że twórcy sztucznej inteligencji - lub same algorytmy - pod wpływem nowych informacji, które podały w wątpliwość te zapisane wcześniej, nanieśli odpowiednie poprawki. Dzięki temu błędowi mogło jednak wyjść na jaw, którzy naukowcy w swoich pracach posiłkowali się informacjami z czatbota bez fact-checkingu oraz jak jedna niesprawdzona informacja może pociągnąć za sobą całą kaskadę zdarzeń. Warto więc wziąć sobie do serca to, co widnieje na samym dole strony popularnej usługi: "ChatGPT może popełniać błędy. Sprawdź ważne informacje".