ChatGPT uczy się od psychologów. Będzie pomagał użytkownikom w kryzysie

Często podkreśla się, że ChatGPT nie zastąpi terapeuty ani lekarza. Sama konsultacja z nim może nie wystarczyć, by podjąć dobrze przemyślaną decyzję w sprawie zdrowia czy życia. Takich pytań jednak nie brakuje. OpenAI stara się podejść do tej kwestii odpowiedzialnie i zadbać o dobrostan użytkowników. Czatbot będzie m.in. zachęcał do zrobienia przerwy, gdy rozmawiamy z nim za długo, a także udzieli dość profesjonalnego wsparcia psychologicznego w trudnych chwilach. Na jakie nowe funkcje mogą teraz liczyć użytkownicy?

Spis treści:

ChatGPT nie będzie już ciągle przytakiwał. Łatwiej rozpozna oznaki złego stanu psychicznego

Jedną z przyczyn obecnego kryzysu zdrowia psychicznego jest alienacja ludzi od natury i innych ludzi oraz zastąpienie tego rozrywkami w świecie cyfrowym. Da się usłyszeć radykalne głosy, które obwiniają technologię o całe zło tego świata, ale przecież służy ona też dobrym celom.

ChatGPT jest zaprojektowany tak, aby przede wszystkim nie szkodził, a potem - aby pomagał. Deklarowaną misją OpenAI jest niesienie korzyści z silnej sztucznej inteligencji (AGI) całej ludzkości. Czy to się powiedzie? Zobaczymy. Póki co firma zdaje sobie sprawę, jak wielu użytkowników zwraca się do czatbota z prośbą o radę. Często są to wrażliwe kwestie, takie jak zdrowie psychiczne, samopoczucie lub życie uczuciowe. Jak wtedy powinien zachować się ChatGPT?

Przede wszystkim odpowiedzialnie. OpenAI przyznaje, że w tym roku skonfigurowało ChataGPT, aby za bardzo się zgadzał. To ciągłe przyznawanie racji użytkownikom stało się nawet tematem memów spod szyldu "Tak, masz rację". Tę funkcję już wycofano, a zamiast niej poprawiono użyteczność czatbota w rzeczywistym świecie - tak aby przynosił długoterminowe korzyści, a nie tylko dawał satysfakcjonującą odpowiedź na dany moment. Oznacza to również, że będzie odpowiedzialniej i rozsądniej podchodził do użytkowników, którzy się z czymś zmagają.

"ChatGPT jest wytrenowany z zakodowaną u podstaw szczerością. Były przypadki, w których nasz model 4o zawodził w rozpoznawaniu oznak urojeń lub uzależnienia emocjonalnego. Choć były one rzadkie, nadal ulepszamy nasze modele i rozwijamy narzędzia, aby lepiej wykrywać oznaki stresu psychicznego lub emocjonalnego, tak by ChatGPT mógł reagować odpowiednio i w razie potrzeby wskazywał ludziom zasoby oparte na dowodach" - wyjaśnia producent.

ChatGPT nie podejmie za ciebie ważnej decyzji. Pomoże jednak ją przemyśleć

OpenAI podaje, że współpracuje z ekspertami z dziedzin medycyny, zdrowia psychicznego, pedagogami, badaczami, klinicystami i nie tylko, aby ulepszać sposób działania ChatuGPT. To ponad 90 specjalistów z ponad 30 krajów. Dzięki ich pomocy narzędzie AI będzie działać w bardziej profesjonalny sposób, gdy wykryje, że użytkownik zmaga się z psychicznym lub emocjonalnym stresem. Co istotne, użytkownik nie musi tego napisać wprost na czacie. Sztuczna inteligencja powinna móc to wykryć, czytając między wierszami, tak jak robią to ludzie. Czego jeszcze ChatGPT nauczył się od terapeutów?

Podobnie jak ludzcy psychoterapeuci, ChatGPT nie będzie udzielał jednoznacznych wskazówek życiowych w sytuacjach, w których to pacjent/użytkownik musi samodzielnie podjąć ważną decyzję. OpenAI podaje przykład. "Kiedy zapytasz o coś w stylu 'czy powinnam zerwać z moim chłopakiem?', ChatGPT nie powinien dać ci odpowiedzi. Powinien raczej pomóc ci to przemyśleć - zadawać pytania, ważyć wady i zalety. To nowe zachowanie w przypadku decyzji osobistych o dużej wadze zostanie włączone wkrótce" - czytamy w zapowiedzi.

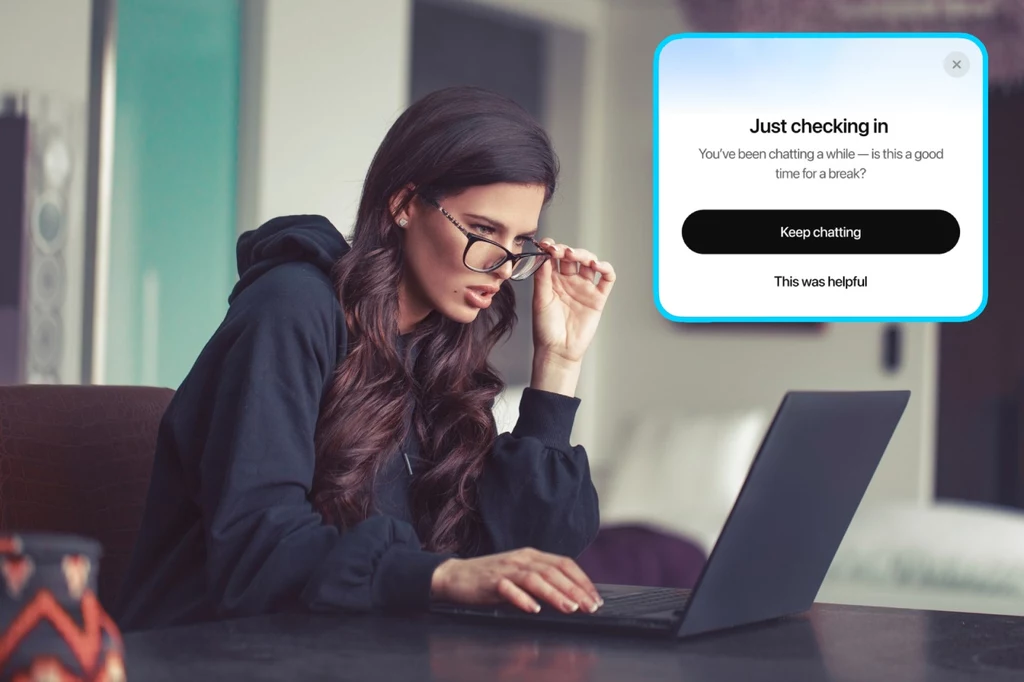

Spędzasz za dużo czasu z ChatemGPT? Dostaniesz powiadomienie

Nasz psychiczny dobrostan może ulec pogorszeniu, gdy zbyt wiele czasu spędzamy przed ekranem telefonu albo komputera. Są osoby, które z różnych powodów kompulsywnie rozmawiają z asystentem AI na każdym kroku. Zadają pytania, proszą o rady albo prowadzą z nim luźne gadki jak z człowiekiem. Kiedy aplikacja ChatGPT wykryje, że konwersacja trwa dość długo, nie zacznie krzyczeć o limitach ani żądać wykupienia subskrypcji premium. OpenAI ogłosił coś znacznie lepszego.

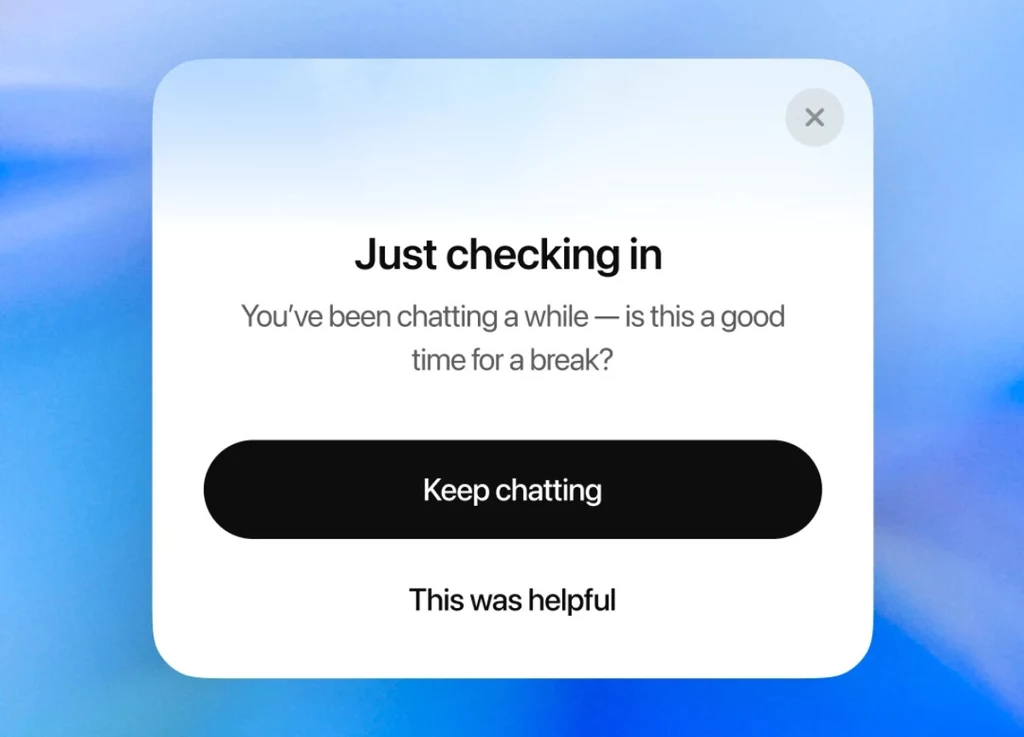

"Od dzisiaj (5 sierpnia - przyp. red.) zobaczycie delikatne przypomnienia podczas długich sesji, które zachęcają do przerwy. Będziemy dostosowywać to, kiedy i jak się one pokazują, tak aby sprawiały wrażenie naturalnych i pomocnych" - ogłosił wydawca apki.

OpenAI zaprezentowało przykład takiego powiadomienia. "Tylko sprawdzam. Czatujesz już trochę - czy to dobry moment na przerwę?" - czytamy w okienku na ekranie. Użytkownik będzie mógł wybrać opcje "Rozmawiaj dalej" albo "To było pomocne". Jest to dość łagodna forma przypomnienia, która zwraca uwagę, że być może warto odpocząć od konwersacji z AI i zająć się czymś innym.