Klon AI ofiary strzelaniny przemówił w sądzie do sprawcy

Sztuczna inteligencja coraz częściej służy do klonowania ludzi - nie takiego prawdziwego, ale jedynie w świecie wirtualnym. Technologia AI odtwarza wizerunek oraz głos na podstawie zdjęć, nagrań wideo i próbek mowy. Jest to wykorzystywane w filmach, serialach i popkulturze, ale także w oszustwach, dezinformacji, cyberprzestępczości i... w sądach. Doszło bowiem do pierwszego takiego użycia cyfrowego klona na rozprawie sądowej. Kompromitujące przypadki zdarzały się już jednak w przeszłości.

Spis treści:

- Ofiara morderstwa przemówiła po latach dzięki AI

- Sztuczna inteligencja zamiast adwokata w sądzie

- Prawnicy korzystają z ChatGPT. Kompromitujące efekty

Ofiara morderstwa przemówiła po latach dzięki AI

Treści wygenerowane przez sztuczną inteligencję raczej znajdują się po drugiej stronie w rozprawach sądowych - jako rzeczy wykorzystane nielegalnie w oszustwach albo fabrykowaniu dowodów. Sędziowie mają ich już dość. Z drugiej strony AI może też pomagać w przebiegu rozprawy. Takie wideo przy pomocy sztucznej inteligencji stworzyła rodzina ofiary morderstwa.

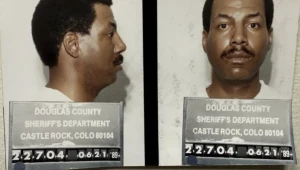

Chris Pelkey został zastrzelony w 2021 roku w incydencie agresji drogowej (tzw. road rage). Jego rodzina przedstawiła wideo z wygenerowanym wizerunkiem i głosem, na którym cyfrowa postać przemawia do oprawcy. Film został wyświetlony na rozprawie w sądzie. Na wstępie tego poruszającego oświadczenia awatar wyjaśnia, że jest cyfrową wersją odtworzoną na podstawie zdjęć i nagrań głosu.

"Do Gabriela Horcasitasa, człowieka, który mnie zastrzelił - szkoda, że spotykamy się w tym dniu w takich okolicznościach. W innym życiu prawdopodobnie moglibyśmy zostać przyjaciółmi" - powiedział cyfrowy klon zamordowanego 37-latka.

Rodzina wygenerowała klip, prawdopodobnie wprowadzając do modelu generatywnego zdjęcia i nagrania Chrisa Pelkeya z czasów, gdy jeszcze żył. Użyli także filtru postarzającego, aby pokazać, jak mógłby wyglądać w przyszłości. "To najlepszy sposób, w jaki mogę wam pokazać, jak bym wyglądał, gdybym miał szansę się zestarzeć. Pamiętajcie, dożycie starości to prezent, na który nie każdy może liczyć, więc przestańcie się martwić o te zmarszczki" - mówi deepfake.

Gabriel Horcasitas został skazany za morderstwo na 10,5 roku więzienia. Jak powiedział sędzia orzekający wyrok, na decyzję o takiej karze przynajmniej częściowo wpłynęło oświadczenie wygenerowane przez AI. Tym razem wydźwięk deepfake'a był jak najbardziej pozytywny. Czasem jednak dochodzi do incydentów sądowych, w których nowe technologie są używane w nierozsądny sposób. Dziś jeszcze łatwo jest wykryć fejka gołym okiem, ale możliwe, że za parę lat nawet biegli sądowi będą mieli z tym problem.

Sztuczna inteligencja zamiast adwokata w sądzie

Miesiąc przed tymi wydarzeniami inna osoba także puściła deepfake'a na rozprawie. To 74-letni Jerome Dewald, który w sądzie w Nowym Jorku wyświetlił nagranie, na którym postać mówiła do kamery. Miał to być rzekomo jego obrońca w sprawie przeciwko byłemu pracownikowi. Sędzia zapytał, czy osoba na ekranie to jego prawnik. Gdy wyszło na jaw, że Dewald bronił się przy pomocy sztucznej inteligencji, sędzia nie był zachwycony, a 74-latek powiedział później, że nie było jego zamiarem wprowadzanie sądu w błąd.

Rodzi się jednak pytanie, czy zamiast opłacać adwokatów, osoby uczestniczące w rozprawach sądowych mogłyby jako linię obrony wykorzystać sztuczną inteligencję. Taki wytrenowany w prawie czatbot mógłby w czasie rzeczywistym odpowiadać na pytania sądu i bronić oskarżonego. Niewykluczone, że tak będzie właśnie wyglądać przyszłość sądownictwa. Najpierw jednak trzeba rozważyć, co z licencją adwokata.

Prawnicy korzystają z ChatGPT. Kompromitujące efekty

Prawnicy, podobnie jak przedstawiciele innych zawodów, również korzystają z pomocy ChatGPT. To jednak problematyczne. Sztuczna inteligencja nadal ma halucynacje - zmyśla odpowiedzi, kiedy brakuje jej danych. Nie można więc w 100% na niej polegać. Doświadczony profesjonalista korzysta z czatbota jedynie jako pomocy. Asystent nie powinien mieć pełnej autonomii, zwłaszcza w tak delikatnej materii, jak rozprawa sądowa.

Jako że nie da się już dziś uniknąć wykorzystania AI, to można zrobić krok naprzód i zamiast ChatuGPT używać specjalnie wytrenowanych na dużych zestawach danych asystentów AI. Modele sztucznej inteligencji - te same, na których opiera się ChatGPT - są dostępne dla deweloperów. Każdy może wykupić subskrypcję, nakarmić model danymi i skonfigurować go we właściwej specjalizacji.

Wielu prawników zdaje się jednak iść na łatwiznę, stąd też liczne przypadki kompromitacji na salach sądowych. Zdarzało się, że przedstawione przez nich materiały zawierały halucynacje, wliczając w to kompletnie sfabrykowane nazwy spraw, fakty i cytaty. Better call Saul! Albo i lepiej...